大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五关于Llama 3,又有测试结果新鲜出炉—— 大模型评测社区LMSYS发布了一份大模型排行榜单,Llama 3位列第五,英文单项与GPT-4并列第一。

关于Llama 3,又有测试结果新鲜出炉—— 大模型评测社区LMSYS发布了一份大模型排行榜单,Llama 3位列第五,英文单项与GPT-4并列第一。

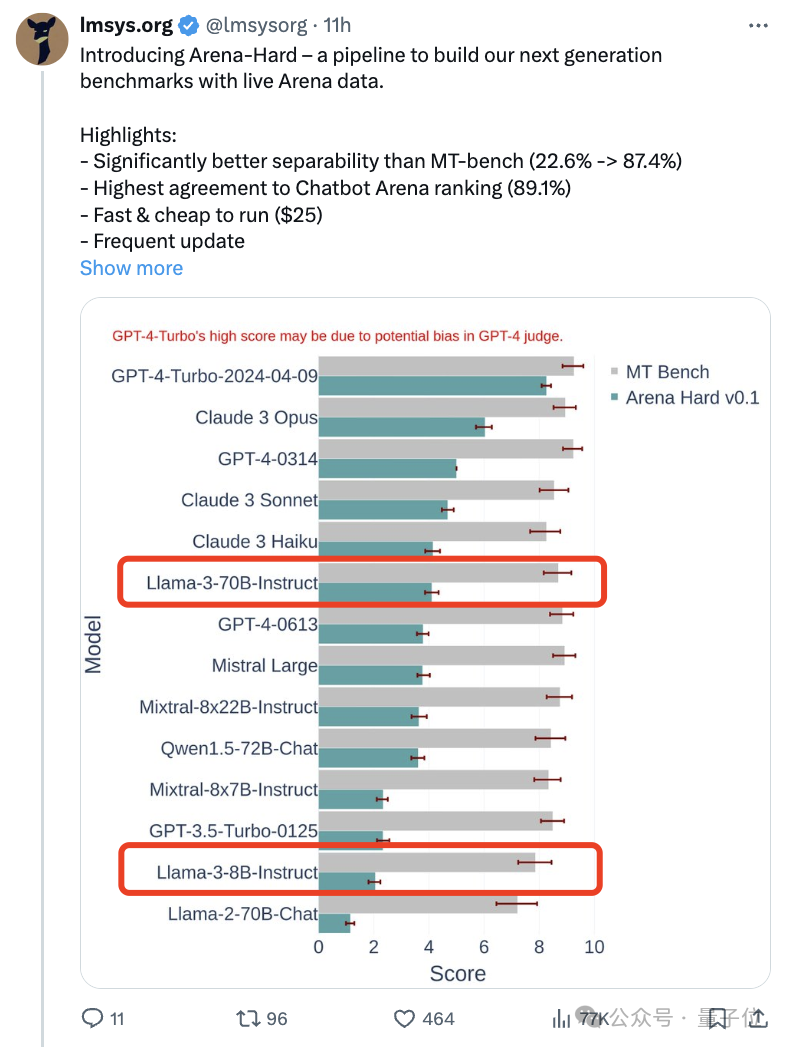

随着Claude 3、Llama 3甚至之后GPT-5等更强模型发布,业界急需一款更难、更有区分度的基准测试。

Llama 3诞生之后便艳压群雄,开源界已无「模」能敌。

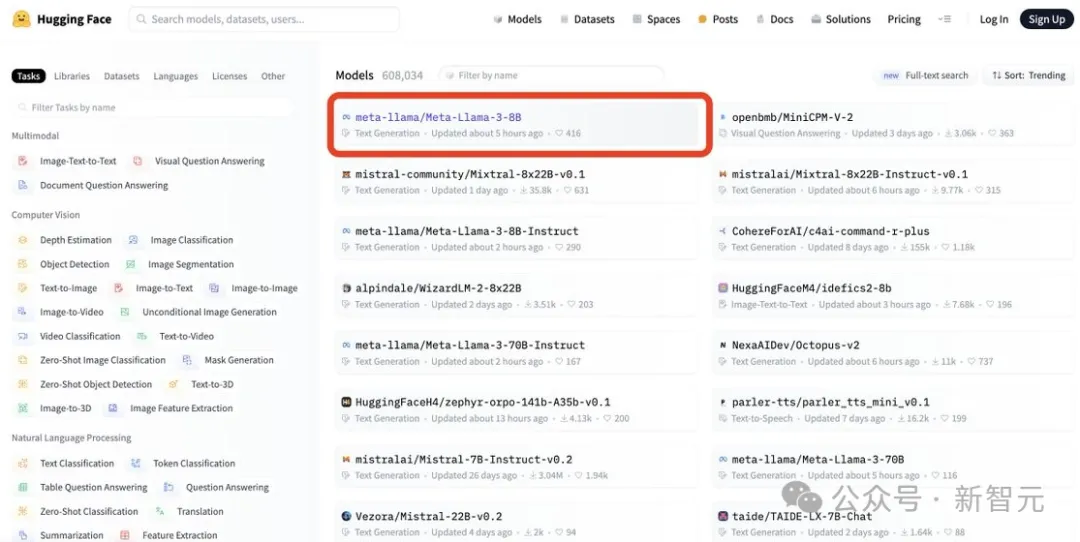

就在刚刚,Meta官网上新,官宣了Llama 3 80亿和700亿参数版本

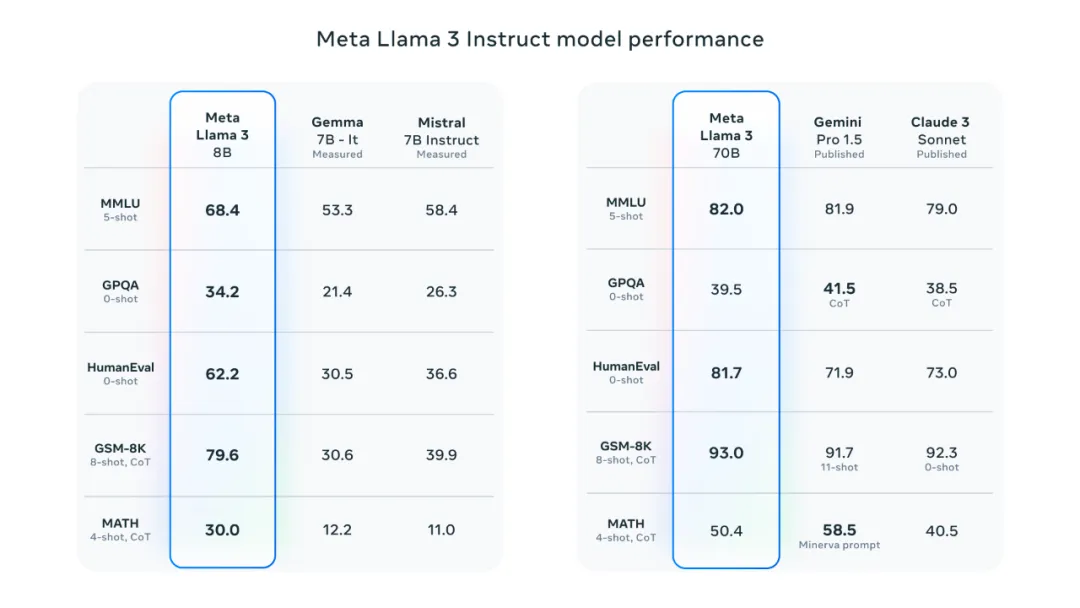

智东西4月19日消息,Meta推出迄今为止能力最强的开源大模型Llama 3系列,发布8B和70B两个版本。 Llama 3在一众榜单中取得开源SOTA(当前最优效果)。Llama 3 8B在MMLU、GPQA、HumanEval、GSM-8K等多项基准上超过谷歌Gemma 7B和Mistral 7B Instruct。

LLM界的「真·Open AI」,又来整顿AI圈了!

ChatGPT 拉开了大模型竞赛的序幕,Meta 似乎要后来居上了。 本周四,AI 领域迎来重大消息,Meta 正式发布了人们等待已久的开源大模型 Llama 3。

Meta 于本周四正式发布 Llama 3,官方号称「有史以来最强大的开源大模型」。

继Mamba之后,又一敢于挑战Transformer的架构诞生了!

一条磁力链,Mistral AI又来闷声不响搞事情。